반응형

많은 사람들이 ChatGPT를 처음 써보면 이렇게 말합니다. “진짜 사람 같아!” 그렇다면, 어떻게 AI가 사람처럼 자연스럽게 말할 수 있을까요? 그 중심에는 바로 RLHF(Reinforcement Learning from Human Feedback)라는 기술이 있습니다. 이 글에서는 RLHF가 무엇인지, 어떻게 작동하며 왜 중요한지를 전문지식 없이도 이해할 수 있도록 쉽게 설명해드릴게요.

✅ RLHF란 무엇인가요?

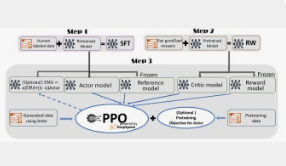

RLHF는 “사람의 피드백을 바탕으로 인공지능을 훈련시키는 방식”입니다. AI가 생성한 여러 답변 중 어떤 것이 더 좋은지, 사람이 직접 평가하고 그 결과를 AI가 학습하게 하는 구조예요.

이 방식은 기존의 단순한 데이터 학습과는 달리, “사람이 진짜 원하는 답변”에 가까워지도록 도와줍니다.

✅ 작동 방식 요약

- AI가 여러 개의 답변을 생성합니다.

- 사람이 가장 자연스럽고 유용한 답변을 고릅니다.

- 이 선택 데이터를 바탕으로 AI가 보상을 받으며 강화 학습을 진행합니다.

- 결과적으로 더 사람다운 응답을 만드는 AI로 발전합니다.

✅ 쉽게 이해하는 비유

RLHF는 마치 AI가 과외 선생님에게 피드백을 받으며 실력을 키우는 것과 같아요.

- 학생(AI)이 여러 답안을 제출하면

- 선생님(사람)이 어떤 답이 가장 적절한지 평가해주고

- 그 피드백을 바탕으로 학생이 더 나은 답안을 만들도록 연습합니다.

✅ RLHF가 중요한 이유

| 기존 AI 학습 | RLHF 적용 이후 |

|---|---|

| 정답/오답 위주로 학습 | 사람의 선호도를 반영한 응답 학습 |

| 기계적이고 어색한 문장 생성 | 자연스럽고 공감 가는 표현 사용 |

| 대화 흐름 무시 | 상황에 맞는 대화 유지 가능 |

✅ RLHF가 적용된 대표 사례

- ChatGPT: 사용자 친화적인 대화 응답

- InstructGPT: 명령어에 따라 정확한 답변 제공

- GPT-4, GPT-4o: 더욱 정교한 대화 흐름 유지

✅ 한계점은 없을까?

- 사람의 피드백이 항상 객관적이진 않을 수 있음

- 편향된 학습 결과가 나올 수 있음

- 훈련 비용과 시간 소요가 큼

✅ 요약

- RLHF는 사람의 피드백을 통해 AI를 자연스럽게 훈련하는 방식

- 기존 모델보다 훨씬 부드럽고 인간다운 응답 가능

- ChatGPT가 대화형 AI로 성공한 핵심 비결 중 하나

- 기술적 장점과 함께 윤리적 고려도 필요함

반응형

'AI' 카테고리의 다른 글

| LoRA란? 경량화된 AI 모델 만들기 (3) | 2025.05.14 |

|---|---|

| Attention Mechanism의 핵심 원리 (0) | 2025.05.14 |

| OpenAI의 GPT 시리즈 진화 과정 (0) | 2025.05.13 |

| GAN(생성적 적대 신경망) 쉽게 이해하기 (0) | 2025.05.13 |

| Word2Vec vs FastText 차이 쉽게 이해하기 (0) | 2025.05.12 |